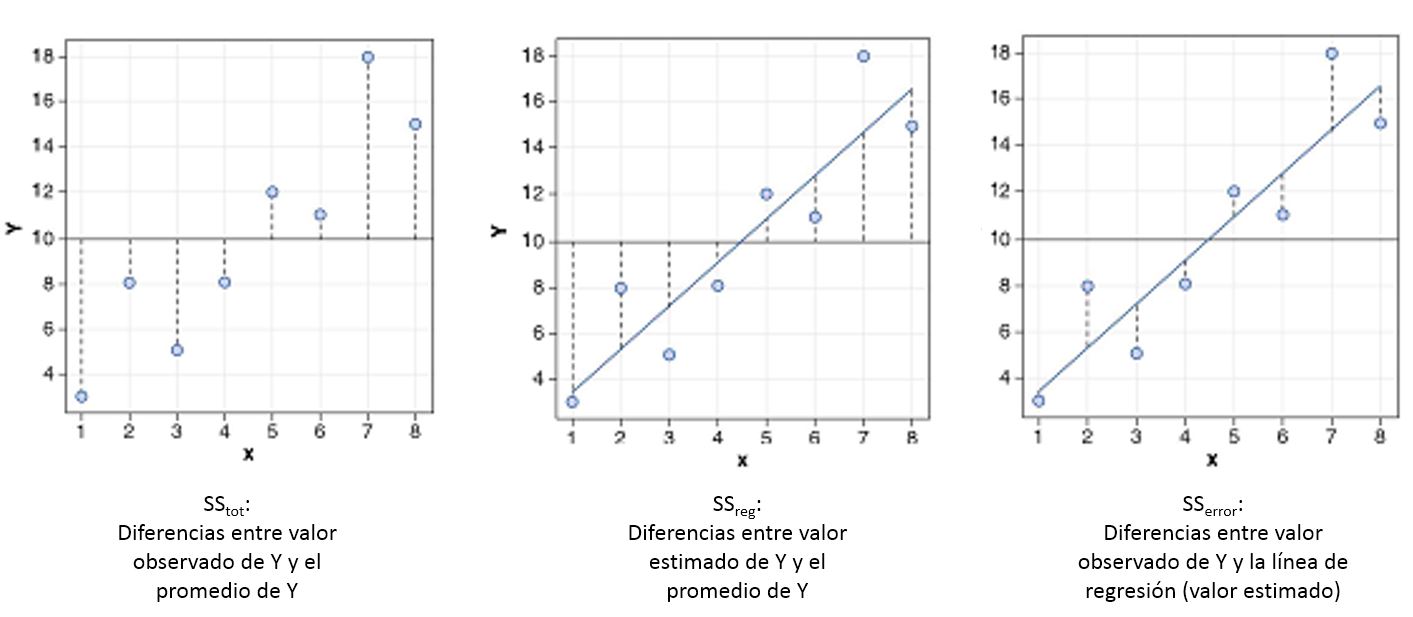

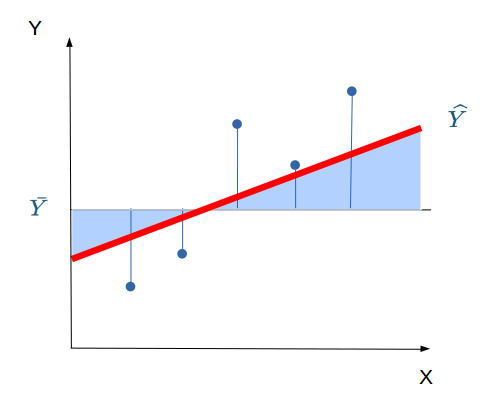

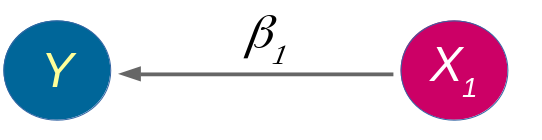

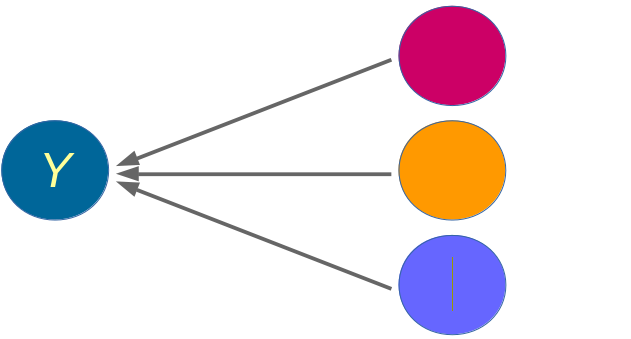

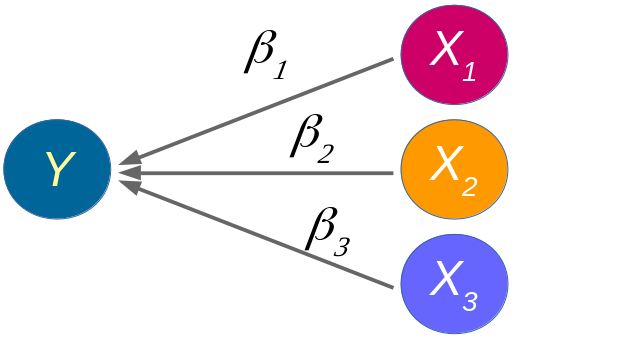

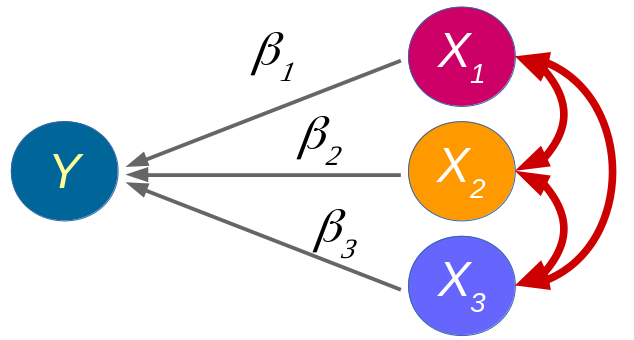

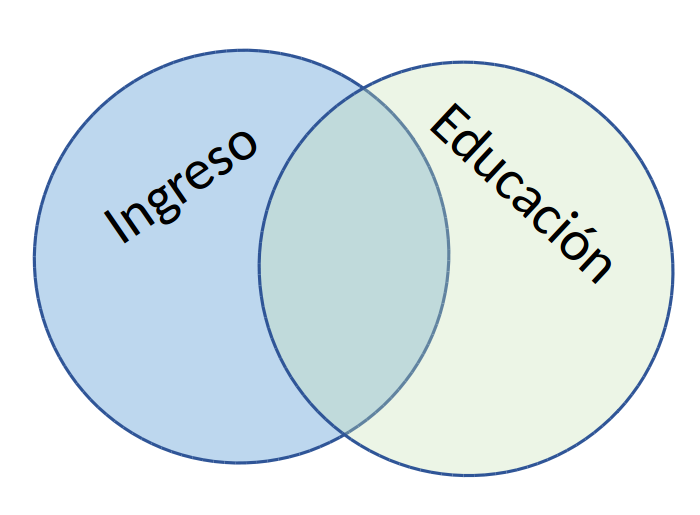

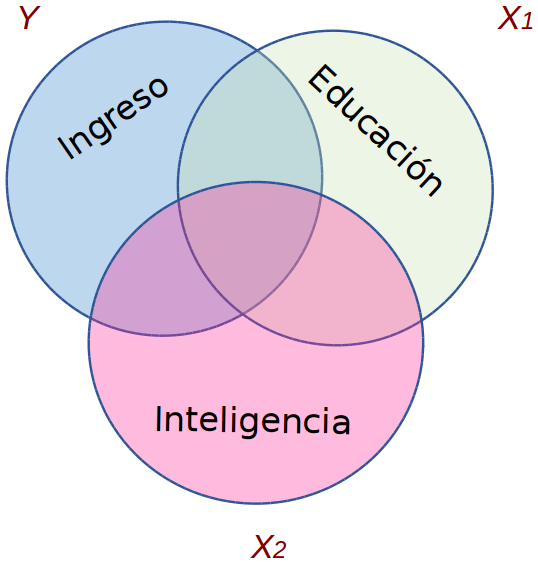

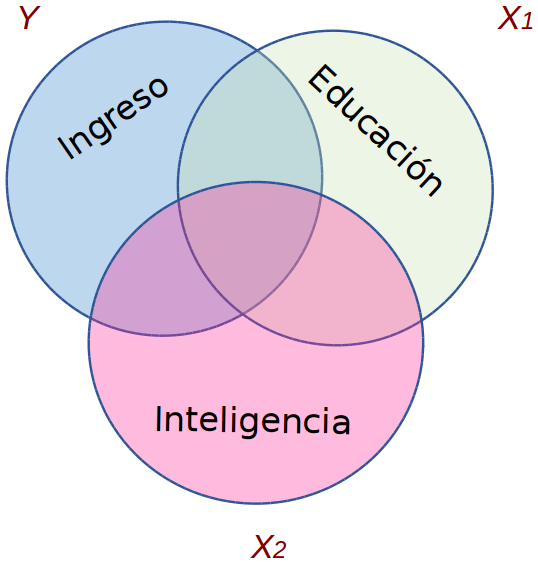

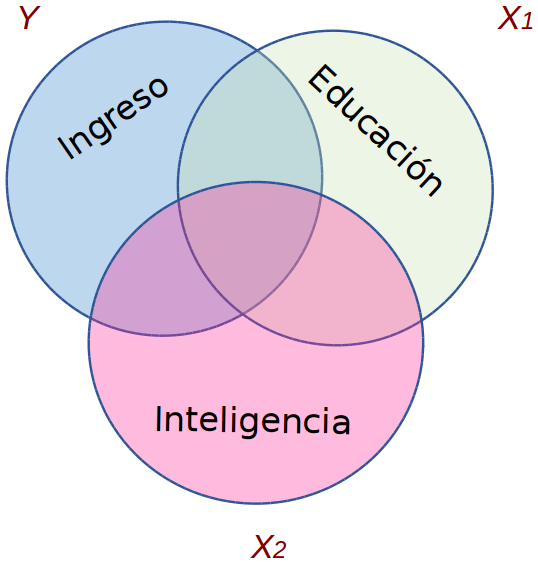

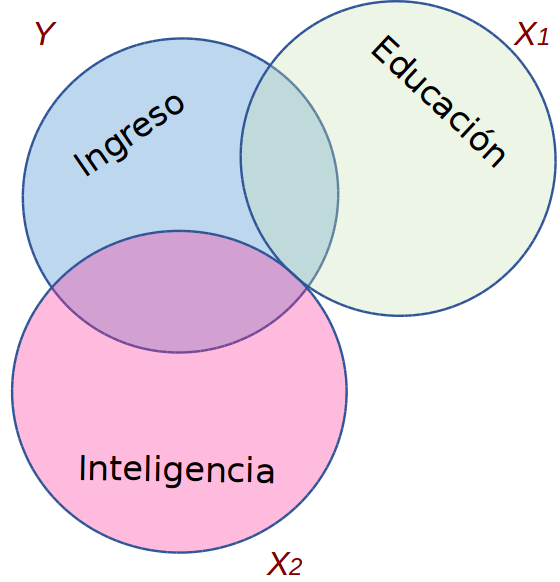

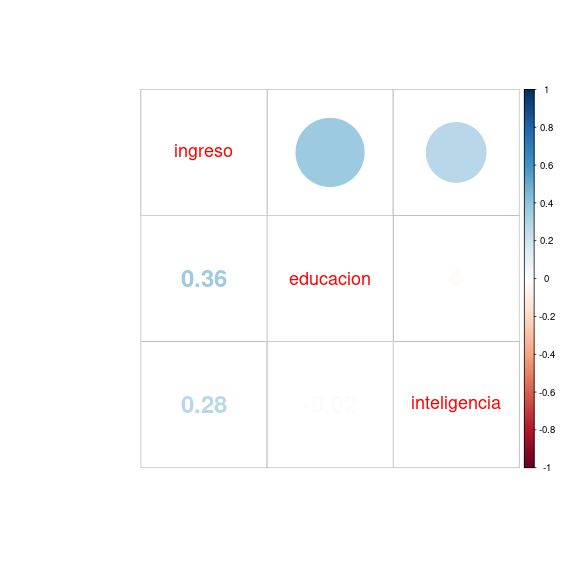

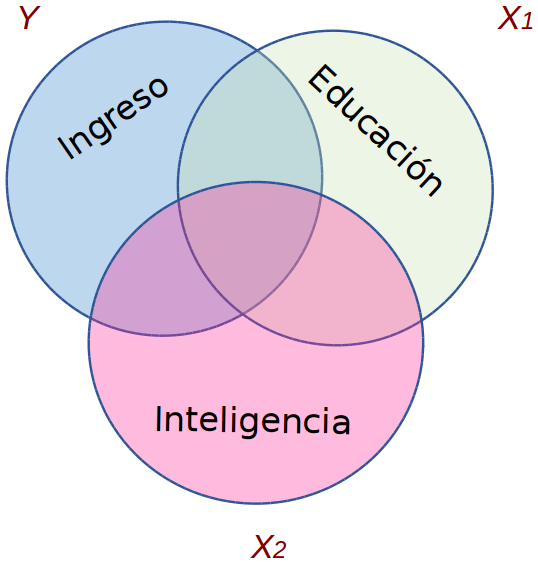

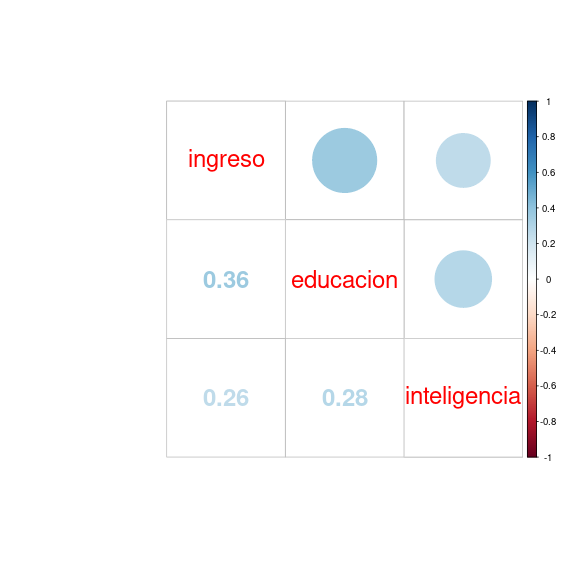

class: front <!--- Para correr en ATOM - open terminal, abrir R (simplemente, R y enter) - rmarkdown::render('static/docpres/07_interacciones/7interacciones.Rmd', 'xaringan::moon_reader') About macros.js: permite escalar las imágenes como [scale 50%](path to image), hay si que grabar ese archivo js en el directorio. ---> .pull-left[ # Estadística Multivariada ## Juan Carlos Castillo ## Sociología FACSO - UChile ## 1er Sem 2022 ## [multivariada.netlify.com](https://multivariada.netlify.com) ] .pull-right[ .right[ <br> ## .purple[Sesión 5: Regresión múltiple (1)]  ] ] --- layout: true class: animated, fadeIn --- class: roja middle center ## Concepto clave de la sesión de hoy: # control estadísitico en regresión múltiple --- class: roja left # Repaso regresión simple --- # Componentes de la ecuación de la recta de regresión `$$\widehat{Y}=b_{0} +b_{1}X$$` Donde - `\(\widehat{Y}\)` es el valor estimado de `\(Y\)` - `\(b_{0}\)` es el intercepto de la recta (el valor de Y cuando X es 0) - `\(b_{1}\)` es el coeficiente de regresión, que nos dice cuánto aumenta Y por cada punto que aumenta X --- .pull-left[ # Resumiendo: Modelo de regresión (simple)  - Se estima mediante el método de mínimos cuadrados ordinarios (OLS) ] -- .pull-right[ {{content}} ] -- - Permite estimar el valor de una variable ( `\(\widehat{Y}\)` ) a partir del valor conocido de otra variable ( `\(X\)` ) {{content}} -- - La estimación se expresa en el coeficiente de regresión `\(b_{1}\)`, también llamado "beta" o pendiente {{content}} -- - *"Por cada unidad que aumenta X, Y aumenta en `\(b_{1}\)` unidades"* {{content}} --- # Descomponiendo Y `$$SS_{tot}=SS_{reg} + SS_{error}$$` .center[  ] --- # Varianza explicada II .pull-left[ .center[] ] .pull-right[ - Un porcentaje de la variación de Y puede ser asociado a la variación de X: `\(R^2\)`] --- class: inverse ### Resumen regresión simple ... hasta ahora - Coeficiente de regresión por mínimos cuadrados: permite **predecir** en cuántas unidades aumenta _Y_ por cada punto de aumento en _X_ -- - El valor del **beta de regresión** nos informa sobre una magnitud y sentido de la pendiente, no sobre la bondad (ajuste) del modelo -- - El **ajuste** del modelo a los datos se relaciona con la proporción de residuos generados por el modelo respecto de la varianza total de Y (R2) --- class: roja left .left[ # Introducción #a regresión múltiple ] --- # Estadística multivariada - Hacia la **explicación** de los fenómenos sociales <br> .center[  ] --- # Estadística multivariada - Hacia la **explicación** de los fenómenos sociales .center[  ] `$$\widehat{Y}=\beta_{0} +\beta_{1}X_{1}$$` --- # Estadística multivariada - Hechos sociales: **multicausales** .center[  ] --- # Estadística multivariada y regresión múltiple - Hechos sociales: **multicausales** .center[  ] `$$\widehat{Y}=\beta_{0} +\beta_{1}X_{1} + \beta_{2}X_{2}+ \beta_{3}X_{3} + \beta_{i}X_{i}$$` --- class: inverse, middle, center .large[ # El modelo de regresión es un modelo .red[SUMATIVO] ] <br> `$$\widehat{Y}=\beta_{0} +\beta_{1}X_{1} + \beta_{2}X_{2}+ \beta_{3}X_{3} + \beta_{i}X_{i}$$` --- class: inverse, center # entonces ... ¿simplemente agregar más predictores al modelo? .medium[ `$$\widehat{ingreso}=\beta_{0} +\beta_{1}educación + \beta_{2}edad+ \beta_{3}género + ... + \beta_{i}X_{i}$$` ] -- # si, .red[pero ...] --- # Posibilidad de predictores correlacionados .center[  ] -- .center[ .red[¿Qué implicancias puede tener para la estimación la correlación entre predictores? ]] --- # Agregando predictores al modelo .pull-left[ .center[] `$$\widehat{Ingreso}=b_0+b_1(Educ)$$` ] -- .pull-right[ .center[] `$$\widehat{Ingreso}=b_0+b_1(Educ)+b_2(Int)$$` ] ??? - Tenemos un modelo teórico que relaciona ingreso con nivel educacional: a mayor ingreso, mayor nivel educacional. - Esto puede expresarse en un modelo de regresión - Qué sucede si nos surge la pregunta sobre la posibilidad de que otras variables también tienen que ver con ingreso? - Se puede agregar una tercera variable al modelo, pero: ¿qué consecuencias teóricas y empíricas tiene esto? --- # Agregando predictores al modelo .pull-left-narrow[ .center[] ] .pull-right-wide[ - Teóricamente el modelo asume covariación entre Ingreso y Educación, y entre _Ingreso_ e _Inteligencia_ {{content}} ] -- - Pero ... también existe la posibilidad de covariación entre los predictores _Educación_ e _Inteligencia_ {{content}} -- - Para poder sumar el efecto neto de cada predictor se debe **controlar** la covariación entre predictores --- class:roja # La regresión múltiple no es equivalente a regresiones simples estimadas por separado con distintos predictores --- class: inverse, middle, center # .large[.yellow[Concepto de .red[control]]] --- .pull-left-narrow[ # 1. Control por diseño <br>  ] .pull-right-wide[ - Característico de la metodología experimental {{content}} ] -- - El control se logra por diseño mediante **aleatorización** (distribución al azar) de sujetos a diferentes situaciones experimentales, generando **grupos equivalentes** {{content}} -- - La aleatorización intenta aislar el **efecto del tratamiento** de todas las otras variables que podrían afectar en la respuesta ] --- ## 2. Control estadístico - En datos observacionales de encuestas en general no hay control por diseño, por lo que se recurre al **control estadístico** -- - En el **modelo de regresión** se logra incluyendo predictores que teóricamente podrían dar cuenta o afectar la relación entre X e Y. -- - La inclusión de **otros predictores** despeja o "controla" la asociación de `\(X_1\)` e `\(Y\)`, aislando el efecto conjunto de `\(X_1\)` y `\(X_2\)` (... y `\(X_n\)`) --- .pull-left-wide[ ## Control estadístico - ¿Qué efecto posee el nivel educacional en ingreso, _controlando por_ inteligencia? ] .pull-right-narrow[  ] **Conceptualmente:** .small[ - aislar el efecto de educación en ingreso, manteniendo la inteligencia _constante_. - estimar el efecto de educación en ingreso independiente del efecto de la inteligencia - estimación del efecto de educación en ingreso _ceteris paribus_ (manteniendo el efecto del resto de los predictores constante) ] --- class: inverse, center, middle, exclude # POR LO TANTO ## Un aspecto **central** en regresión múltiple, tanto conceptual como estadísticamente, tiene que ver con el .yellow[control de la CORRELACION] ENTRE .red[PREDICTORES] O VARIABLES INDEPENDIENTES (X) --- ### Simulación 1: sin correlación relevante entre predictores .pull-left-narrow[ .center[] ] -- .pull-right_wide[.small[ <!-- --> ] ] --- ### Simulación 1: sin correlación relevante entre predictores .small[ <table class="texreg" style="margin: 10px auto;border-collapse: collapse;border-spacing: 0px;caption-side: bottom;color: #000000;border-top: 2px solid #000000;"> <caption> </caption> <thead> <tr> <th style="padding-left: 5px;padding-right: 5px;"> </th> <th style="padding-left: 5px;padding-right: 5px;">Model 1</th> <th style="padding-left: 5px;padding-right: 5px;">Model 2</th> <th style="padding-left: 5px;padding-right: 5px;">Model 3</th> </tr> </thead> <tbody> <tr style="border-top: 1px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">(Intercept)</td> <td style="padding-left: 5px;padding-right: 5px;">-0.15</td> <td style="padding-left: 5px;padding-right: 5px;">-0.15</td> <td style="padding-left: 5px;padding-right: 5px;">-0.16</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.09)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.09)</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">educacion</td> <td style="padding-left: 5px;padding-right: 5px;">0.40<sup>***</sup></td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">0.40<sup>***</sup></td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">inteligencia</td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">0.30<sup>**</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.31<sup>**</sup></td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> </tr> <tr style="border-top: 1px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">R<sup>2</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.13</td> <td style="padding-left: 5px;padding-right: 5px;">0.08</td> <td style="padding-left: 5px;padding-right: 5px;">0.21</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">Adj. R<sup>2</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.12</td> <td style="padding-left: 5px;padding-right: 5px;">0.07</td> <td style="padding-left: 5px;padding-right: 5px;">0.20</td> </tr> <tr style="border-bottom: 2px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">Num. obs.</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> </tr> </tbody> <tfoot> <tr> <td style="font-size: 0.8em;" colspan="4"><sup>***</sup>p < 0.001; <sup>**</sup>p < 0.01; <sup>*</sup>p < 0.05</td> </tr> </tfoot> </table> ] --- ### Simulación 2: con correlación entre predictores .pull-left-narrow[ .center[] ] -- .pull-right-wide[.medium[ <!-- --> ] ] --- ### Simulación 2: con correlación entre predictores .small[ <table class="texreg" style="margin: 10px auto;border-collapse: collapse;border-spacing: 0px;caption-side: bottom;color: #000000;border-top: 2px solid #000000;"> <caption> </caption> <thead> <tr> <th style="padding-left: 5px;padding-right: 5px;"> </th> <th style="padding-left: 5px;padding-right: 5px;">Model 1</th> <th style="padding-left: 5px;padding-right: 5px;">Model 2</th> <th style="padding-left: 5px;padding-right: 5px;">Model 3</th> </tr> </thead> <tbody> <tr style="border-top: 1px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">(Intercept)</td> <td style="padding-left: 5px;padding-right: 5px;">-0.15</td> <td style="padding-left: 5px;padding-right: 5px;">-0.15</td> <td style="padding-left: 5px;padding-right: 5px;">-0.16</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.09)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.09)</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">educacion</td> <td style="padding-left: 5px;padding-right: 5px;">0.40<sup>***</sup></td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">0.35<sup>**</sup></td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.11)</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">inteligencia</td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">0.30<sup>**</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.18</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.11)</td> </tr> <tr style="border-top: 1px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">R<sup>2</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.13</td> <td style="padding-left: 5px;padding-right: 5px;">0.08</td> <td style="padding-left: 5px;padding-right: 5px;">0.16</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">Adj. R<sup>2</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.12</td> <td style="padding-left: 5px;padding-right: 5px;">0.07</td> <td style="padding-left: 5px;padding-right: 5px;">0.14</td> </tr> <tr style="border-bottom: 2px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">Num. obs.</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> </tr> </tbody> <tfoot> <tr> <td style="font-size: 0.8em;" colspan="4"><sup>***</sup>p < 0.001; <sup>**</sup>p < 0.01; <sup>*</sup>p < 0.05</td> </tr> </tfoot> </table> ] --- ## Comparando .pull-left[ .small[ <table class="texreg" style="margin: 10px auto;border-collapse: collapse;border-spacing: 0px;caption-side: bottom;color: #000000;border-top: 2px solid #000000;"> <caption> </caption> <thead> <tr> <th style="padding-left: 5px;padding-right: 5px;"> </th> <th style="padding-left: 5px;padding-right: 5px;">Model 1</th> <th style="padding-left: 5px;padding-right: 5px;">Model 2</th> <th style="padding-left: 5px;padding-right: 5px;">Model 3</th> </tr> </thead> <tbody> <tr style="border-top: 1px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">(Intercept)</td> <td style="padding-left: 5px;padding-right: 5px;">-0.15</td> <td style="padding-left: 5px;padding-right: 5px;">-0.15</td> <td style="padding-left: 5px;padding-right: 5px;">-0.16</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.09)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.09)</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">educacion</td> <td style="padding-left: 5px;padding-right: 5px;">0.40<sup>***</sup></td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">0.40<sup>***</sup></td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">inteligencia</td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">0.30<sup>**</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.31<sup>**</sup></td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> </tr> <tr style="border-top: 1px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">R<sup>2</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.13</td> <td style="padding-left: 5px;padding-right: 5px;">0.08</td> <td style="padding-left: 5px;padding-right: 5px;">0.21</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">Adj. R<sup>2</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.12</td> <td style="padding-left: 5px;padding-right: 5px;">0.07</td> <td style="padding-left: 5px;padding-right: 5px;">0.20</td> </tr> <tr style="border-bottom: 2px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">Num. obs.</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> </tr> </tbody> <tfoot> <tr> <td style="font-size: 0.8em;" colspan="4"><sup>***</sup>p < 0.001; <sup>**</sup>p < 0.01; <sup>*</sup>p < 0.05</td> </tr> </tfoot> </table> ] ] .pull-right[ .small[ <table class="texreg" style="margin: 10px auto;border-collapse: collapse;border-spacing: 0px;caption-side: bottom;color: #000000;border-top: 2px solid #000000;"> <caption> </caption> <thead> <tr> <th style="padding-left: 5px;padding-right: 5px;"> </th> <th style="padding-left: 5px;padding-right: 5px;">Model 1</th> <th style="padding-left: 5px;padding-right: 5px;">Model 2</th> <th style="padding-left: 5px;padding-right: 5px;">Model 3</th> </tr> </thead> <tbody> <tr style="border-top: 1px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">(Intercept)</td> <td style="padding-left: 5px;padding-right: 5px;">-0.15</td> <td style="padding-left: 5px;padding-right: 5px;">-0.15</td> <td style="padding-left: 5px;padding-right: 5px;">-0.16</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.09)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.09)</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">educacion</td> <td style="padding-left: 5px;padding-right: 5px;">0.40<sup>***</sup></td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">0.35<sup>**</sup></td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.11)</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">inteligencia</td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">0.30<sup>**</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.18</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;"> </td> <td style="padding-left: 5px;padding-right: 5px;">(0.10)</td> <td style="padding-left: 5px;padding-right: 5px;">(0.11)</td> </tr> <tr style="border-top: 1px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">R<sup>2</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.13</td> <td style="padding-left: 5px;padding-right: 5px;">0.08</td> <td style="padding-left: 5px;padding-right: 5px;">0.16</td> </tr> <tr> <td style="padding-left: 5px;padding-right: 5px;">Adj. R<sup>2</sup></td> <td style="padding-left: 5px;padding-right: 5px;">0.12</td> <td style="padding-left: 5px;padding-right: 5px;">0.07</td> <td style="padding-left: 5px;padding-right: 5px;">0.14</td> </tr> <tr style="border-bottom: 2px solid #000000;"> <td style="padding-left: 5px;padding-right: 5px;">Num. obs.</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> <td style="padding-left: 5px;padding-right: 5px;">100</td> </tr> </tbody> <tfoot> <tr> <td style="font-size: 0.8em;" colspan="4"><sup>***</sup>p < 0.001; <sup>**</sup>p < 0.01; <sup>*</sup>p < 0.05</td> </tr> </tfoot> </table> ] ] --- # Estimación de parámetros y control estadístico - Los coeficientes de regresión `\(\beta\)` no alteran su valor en los modelos en ausencia de correlación entre predictores `\(X\)` (Ejemplo 1) -- - Si hay correlación entre predictores, el valor de los coeficientes de regresión será distinto en modelos simples y en modelos múltiples -> **control estadístico** -- - Por ello, en regresión múltiple se habla de coeficientes de regresión **parciales** --- # Estimación de parámetros y control estadístico - Ejemplo 2, modelo 3: El ingreso aumenta en 0.4 puntos por cada nivel adicional de educación, **controlando por inteligencia**. O también ... - manteniendo la inteligencia _constante_ - _ceteris paribus_ --- class: inverse ## Resumen - Regresión múltiple: más de un predictor / variable independiente en el modelo - Permite - contrastar hipótesis de la **influencia simultánea** de más de una variable - **controlar** por la posible influencia de terceras variables (control estadístico) --- class: front .pull-left[ # Estadística Multivariada ## Juan Carlos Castillo ## Sociología FACSO - UChile ## 1er Sem 2022 ## [multivariada.netlify.com](https://multivariada.netlify.com) ] .pull-right[ .right[ <br>  ] ]